Der einzige Leitfaden, den Sie benötigen, um ein statistisches Modell für Ihr Experimentieren auszuwählen

Ein statistisches Modell kann die Interpretation, Geschwindigkeit und Robustheit der Ergebnisse Ihres Experimentierens beeinflussen. Welcher Ansatz der beste ist, hängt von den Besonderheiten des Experiments, den verfügbaren Informationen und dem gewünschten Gleichgewicht zwischen Geschwindigkeit und Sicherheit ab.

Die meisten Ratschläge zum Testen sind falsch...

Sie haben es wahrscheinlich schon gehört...

"Sequentielle Tests sind immer besser."

"Ein fester Zeithorizont ist der Goldstandard."

"Bayesianisch ist die Zukunft."

Ich habe gesehen, wie Unternehmen diese Ratschläge befolgt und trotzdem schlechte Entscheidungen getroffen haben.

Die Wahrheit? Es gibt keine Methode, die für alle passt. Ihr statistischer Ansatz sollte Ihrer geschäftlichen Realität entsprechen, nicht einem Lehrbuchideal. Es geht nicht um mathematische Eleganz, sondern um die Anpassung an Ihre spezifischen geschäftlichen Zwänge, zeitlichen Anforderungen und Entscheidungsprozesse.

Heute werde ich Ihnen genau zeigen, wie Sie den richtigen statistischen Ansatz für Ihre spezifische Situation auswählen. Es gibt keine universellen Proklamationen, sondern nur praktische Entscheidungsrahmen, die in der realen Welt funktionieren.

Was dieser Leitfaden abdecken wird

- Die wichtigsten statistischen Ansätze und wann jeder von ihnen seine Stärken hat (nicht, welcher Ansatz "besser" ist)

- Reale geschäftliche Auswirkungen Ihrer statistischen Wahl (das "so what", das zählt)

- Praktischer Entscheidungsrahmen für die Auswahl Ihres Ansatzes (kein Rätselraten mehr)

- Häufige Fallstricke und wie Sie sie vermeiden können (lernen Sie aus den Fehlern anderer)

Am Ende dieses Leitfadens werden Sie in der Lage sein, die richtige Wahl für Ihr Programm zu treffen.

Die zwei statistischen Denkschulen

Auf höchster Ebene gibt es zwei grundlegende statistische Philosophien:

1. Frequentistische Statistik

Interpretiert die Wahrscheinlichkeit als die langfristige Häufigkeit von Ereignissen. Wenn jemand von "p-Werten","statistischer Signifikanz" oder "95% Konfidenzintervallen" spricht, dann ist das frequentistisch.

Das ist so, als würde man sagen: "Wenn wir dieses Experiment 100 Mal durchführen würden, würden wir dieses Ergebnis oder ein noch extremeres Ergebnis weniger als 5 Mal durch reinen Zufall sehen."

DieFehlerkontrolle bei frequentistischen Ansätzen konzentriert sich auf die Beherrschung von zwei Arten von Fehlern:

- Fehler vom Typ I (falsch positiv): Die Schlussfolgerung, dass es einen Effekt gibt, obwohl es keinen gibt. So wie die Behauptung, dass Ihre neue Funktion die Conversion verbessert hat, obwohl dies nicht der Fall ist.

- Fehler vom Typ II (falsch negativ): Das Übersehen einer echten Wirkung. Zum Beispiel die Schlussfolgerung, dass Ihre Funktion keine Auswirkungen hatte, obwohl sie die Conversion verbessert hat.

In der Praxis kontrollieren Frequentisten in der Regel den Fehler vom Typ I (der in den meisten Experimenten bei 5% liegt), während der Fehler vom Typ II durch die statistische Aussagekraft (in der Regel 80%) gesteuert wird.

2. Bayessche Statistik

Behandelt die Wahrscheinlichkeit als einen Grad der Überzeugung. Anstatt zu fragen: "Wie groß ist die Wahrscheinlichkeit, dass diese Daten auftauchen, wenn es keinen Effekt gibt?" (frequentistisch), sondern "Wie hoch ist die Wahrscheinlichkeit, dass es bei diesen Daten tatsächlich einen Effekt gibt?"

In der Bayes'schen Sprache heißt das soviel wie: "Basierend auf dem, was wir wissen und was wir beobachtet haben, besteht eine 80%ige Wahrscheinlichkeit, dass diese Variante besser ist."

DieFehlerkontrolle bei Bayes'schen Ansätzen ist grundlegend anders. Anstatt Fehlerquoten über hypothetische wiederholte Experimente zu kontrollieren, drücken Bayesianer die Unsicherheit direkt durch Wahrscheinlichkeitsverteilungen aus.

Anstelle von binären Entscheidungen mit Fehlerquoten könnten Bayesianer sagen: "Die Wahrscheinlichkeit, dass der wahre Effekt zwischen 2 % und 5 % liegt, beträgt 95 %" und bietet damit einen intuitiveren Rahmen für die Entscheidungsfindung unter Unsicherheit.

Die drei wichtigsten Testansätze

Schauen wir uns die wichtigsten Ansätze an und wann jeder von ihnen seine Stärken hat:

1. Testen mit festem Zeithorizont: Das traditionelle Arbeitspferd

Was es ist: Die Statistik, die Sie in der Schule gelernt haben. Sie berechnen im Voraus eine Stichprobengröße, führen sie durch, bis Sie sie erreicht haben, und werfen vor dem Ende keinen Blick auf die Ergebnisse.

Wenn es glänzt:

- Wissenschaftliche/regulierte Umgebungen

- Vorhersehbare Zeitpläne und Datenverkehr

- Wohlverstandene Effektgrößen

- Kontexte zur Einhaltung von Vorschriften

Geschäftliche Auswirkungen: Als würde man einen Vorschlaghammer benutzen, um ein Bild aufzuhängen. Zuverlässig und effizient für digitales Experimentieren.

Die Wissenschaft dahinter: Kontrolliert falsch-positive Ergebnisse (Fehler vom Typ I) auf genau 5%, wenn Sie die Regeln perfekt befolgen. Aber wenn Sie zu früh aufschauen oder den Test verlängern, kann Ihre Falsch-Positiv-Rate auf 20-30% oder in manchen Fällen sogar auf 100% ansteigen.

Beispiel: Während viele wissenschaftliche Studien mit einem festen Zeithorizont durchgeführt werden, werden selbst in stark regulierten Branchen wie der Pharmaindustrie häufig ausgefeilte Zwischenanalysen in die Studienplanung integriert. Diese Zwischenanalysen müssen jedoch im Voraus geplant werden und mehrere Tests berücksichtigen, um die statistische Aussagekraft zu erhalten.

2. Frequentistische sequentielle Analysen: Validierung von "Peeking"

Was es ist: Ein Testansatz, der eine kontinuierliche Überwachung mit statistisch validen Frühstopps ermöglicht. Einige sequentielle Methoden verwenden zwar frequentistische Begriffe (p-Werte, Konfidenzintervalle), passen aber nicht in das traditionelle frequentistische Paradigma.

Wenn es glänzt:

- Digitales Experimentieren mit variablem Datenverkehr

- Wenn Sie die Flexibilität brauchen, Tests frühzeitig zu beenden

- Wenn die Opportunitätskosten für die Durchführung unnötig langer Tests hoch sind

Geschäftliche Auswirkungen: Sie können Ihr Testprogramm flexibler gestalten und gleichzeitig die statistische Strenge beibehalten.

Die Wissenschaft dahinter: Methoden wie mSPRT passen die Schwellenwerte für die Evidenz an, je nachdem, wie oft Sie die Ergebnisse überprüfen, und sorgen so für eine valide Fehlerkontrolle während des gesamten Experiments.

Beispiel: Ein E-Commerce-Unternehmen kann einen Test schnell stoppen, wenn ein neuer Checkout-Flow signifikante Conversion-Einbrüche zeigt, und so den Umsatzverlust minimieren.

Der Nachteil: Es dauert länger, bis Sie zu einem Ergebnis kommen, wenn es wirklich keinen Effekt gibt. Der Preis für die Flexibilität, wenn die Auswirkungen real sind.

3. Bayesianisches Testen: Die intuitive Alternative

Was es ist: Ein anderer Ansatz, der Vorwissen einbezieht und direkt die Wahrscheinlichkeit angibt, dass eine Variante besser ist.

Wann er glänzt:

- Begrenzte Stichprobengrößen

- Historische Daten verfügbar

- Erläuterung der Ergebnisse für die Beteiligten

Geschäftliche Auswirkungen: Intuitivere Ergebnisse ("80 % Wahrscheinlichkeit, dass Variante B besser ist") und potenziell schnellere Entscheidungen mit guten Vorabinformationen.

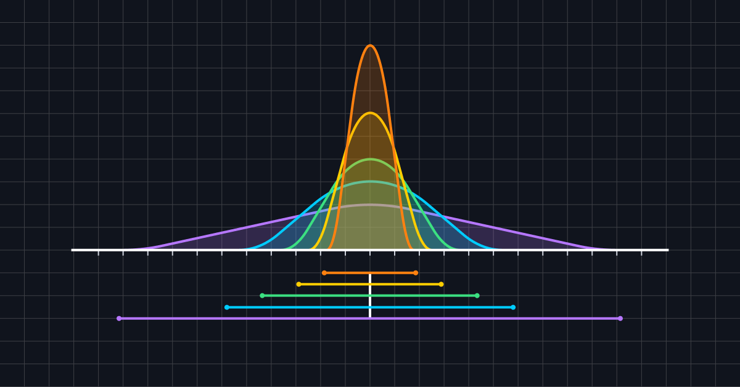

Die Wissenschaft dahinter: Kombiniert Vorannahmen mit beobachteten Daten, um Wahrscheinlichkeitsverteilungen über Effektgrößen zu erstellen. Die Qualität Ihrer Prioritäten wirkt sich dramatisch auf die Ergebnisse aus.

Beispiel: Ein Produktteam, das über umfangreiche historische Daten verfügt, kann dieses Wissen in neue Tests einfließen lassen und Entscheidungen mit kleineren Stichprobengrößen treffen.

Ein Missverständnis: Weder die Bayes'schen noch die frequentistischen Methoden eliminieren falsch-positive Ergebnisse. Sie drücken die Unsicherheit unterschiedlich aus und können mehr "Gewinner" identifizieren, weil sie unterschiedliche Fehlerkontrollmechanismen verwenden.

Kurzreferenz: Wählen Sie Ihren Ansatz

Sie müssen schnell eine Entscheidung treffen? Hier ist Ihr Spickzettel:

| Ansatz | Wann zu verwenden | Vorteile | Beschränkungen |

| Fester Zeithorizont |

|

|

|

| Sequentiell |

|

|

|

| Bayesianisch |

|

|

|

Entscheidungsrahmen für Ihren statistischen Ansatz

Vergessen Sie die Frage "Welche Methode ist besser?" Das ist die völlig falsche Frage.

Stellen Sie stattdessen diese Fragen, um den richtigen Ansatz für Ihre spezielle Situation zu finden:

1. Was sind Ihre geschäftlichen Zwänge?

- Müssen Sie Effekte so schnell wie möglich feststellen?

- Ist Ihre Stichprobengröße begrenzt?

- Wie wichtig ist die Interpretierbarkeit für nicht-technische Interessengruppen?

- Wie wichtig ist es, mögliche negative Erlebnisse auf ein Minimum zu beschränken?

2. Welche Datenvorteile haben Sie?

- Verfügen Sie über zuverlässige historische Daten zu ähnlichen Tests?

- Wie variabel sind Ihre Metriken?

- Wie viele Metriken und Variationen testen Sie gleichzeitig?

- Verfügen Sie über Fachexperten, die fundierte Vorhersagen machen können?

3. Was sind Ihre Prioritäten bei der Fehlerkontrolle?

- Ist die Begrenzung falsch positiver Ergebnisse für Ihr Unternehmen entscheidend?

- Sind falsch negative Ergebnisse (verpasste Chancen) kostspieliger?

- Brauchen Sie Wahrscheinlichkeitsaussagen über Auswirkungen?

- Wie hoch sind die Kosten für eine falsche Entscheidung in die eine oder andere Richtung?

4. Was ist der organisatorische Kontext?

- Müssen Sie etablierte wissenschaftliche Protokolle befolgen?

- Wie reif ist Ihr Programm zum Experimentieren?

- Welche Hilfsmittel stehen Ihnen zur Verfügung?

- Wie hoch ist die statistische Kompetenz Ihrer Stakeholder?

Häufige Fehler, die Sie vermeiden können...

Ich habe gesehen, dass Teams bei jedem Ansatz immer wieder die gleichen Fehler machen. Hier erfahren Sie, wie Sie sie vermeiden können:

1. Testen mit festem Zeithorizont

- Sie schauen sich die Ergebnisse an, bevor Sie die vorgegebene Stichprobengröße erreicht haben (dadurch wird Ihr gesamter Test ungültig)

- Ausdehnung der Tests über die geplante Stichprobengröße hinaus, wenn die Ergebnisse nicht signifikant sind ("optionales Stoppen" erhöht die Zahl der falsch-positiven Ergebnisse dramatisch)

- Verwendung willkürlicher Stichprobengrößen anstelle ordnungsgemäßer Leistungsberechnungen (führt zu Tests mit zu geringer Leistung oder Verschwendung)

- Ignorieren von geschäftlichen Zwängen zugunsten statistischer Reinheit (das Perfekte ist der Feind des Guten)

2. Sequentielle Tests

- Erwartung schneller Ergebnisse für Tests mit minimalen oder keinen Auswirkungen (sequenzielle Tests dauern länger, wenn es keine Auswirkungen gibt)

- Missverstehen der Auswirkungen auf die Aussagekraft von Tests mit geringen Auswirkungen (sequenzielle Tests haben unterschiedliche Aussagekraftmerkmale)

- Übermäßiges Vertrauen in frühe Ergebnisse ohne Berücksichtigung der geschäftlichen Auswirkungen (statistische Signifikanz ≠ geschäftliche Signifikanz)

- Verwendung der falschen sequentiellen Methode für Ihre spezifischen Bedürfnisse (nicht alle sequentiellen Ansätze sind gleich)

3. Bayesianisches Testen

- Betrachten Sie Priors als Ihre informierte Vermutung, bevor Sie den Test durchführen. Es ist so, als ob Sie mit etwas Erfahrung in der Tasche wetten würden.

- Fehlinterpretation von Posterior-Wahrscheinlichkeiten in geschäftlichen Kontexten

- Vernachlässigung der Sensitivitätsanalyse Ihrer Prior-Entscheidungen (wie stark beeinflussen Ihre Prioren Ihre Schlussfolgerungen?)

Die Wahl Ihres statistischen Ansatzes ist jedoch nur die Grundlage. Es gibt Techniken, mit denen Sie Ihre Ergebnisse verbessern können.

- Varianzreduzierung: Techniken wie CUPED (Controlled-experiment Using Pre-Existing Data) oder das Ausreißermanagement können den für alle Ansätze erforderlichen Stichprobenumfang durch die Einbeziehung von Daten aus der Zeit vor dem Experiment drastisch reduzieren. CUPED ist ansatzunabhängig und kompatibel mit Methoden mit festem Zeithorizont, sequentiellen und Bayes'schen Methoden.

- Korrektur von Mehrfachtests: Wenn Sie mehrere Metriken oder Variationen gleichzeitig testen, müssen Sie die erhöhte Wahrscheinlichkeit von falsch-positiven Ergebnissen berücksichtigen.

Es gibt zwei Hauptansätze:

- Familienspezifische Fehlerrate (FWER): Sie kontrolliert die Wahrscheinlichkeit, auch nur eine falsche Entdeckung zu machen.

- Fehlfindungsrate (FDR): Sie kontrolliert den erwarteten Anteil der falschen Entdeckungen unter allen Entdeckungen.

Beide dienen unterschiedlichen Zwecken und sind mit unterschiedlichen Kompromissen bei der statistischen Aussagekraft verbunden. Entscheidend ist, dass Sie wissen, welche Methode zu Ihren Geschäftszielen passt.

Der Ansatz von Optimizely...

Stats Engine setzt einen neuartigen Algorithmus ein, den sogenannten Mixture Sequential Probability Ratio Test (mSPRT).

Er vergleicht nach jedem Besucher, um wie viel aussagekräftiger die Daten für eine Verbesserung / Nicht-Null-Verbesserung im Vergleich zu Null / gar keine Verbesserung sind. Dies ist die relative Plausibilität der Veränderung(en) im Vergleich zur Basislinie.

Der mSPRT ist eine besondere Art von statistischem Test, der den sequentiellen Wahrscheinlichkeitsquotiententest (SPRT) verbessert, der erstmals 1985 von dem theoretischen Statistiker David Siegmund in Stanford vorgeschlagen wurde. Dieser OG sequentielle Wahrscheinlichkeitsverhältnistest von Siegmund wurde entwickelt, um exakte, spezifische Werte des Auftriebs einer einzelnen Variation im Vergleich zu einer einzelnen Kontrolle zu testen, indem man die Wahrscheinlichkeit vergleicht, dass es eine Leistungsverbesserung ungleich Null durch die Variation gegenüber einer Leistungsverbesserung von Null gegenüber der Basislinie gibt.

Der mSPRT-Algorithmus von Optimizely bildet den Durchschnitt der gewöhnlichen SPRT über einen Bereich aller möglichen Verbesserungen (z.B. alternative Auftriebswerte).

Die Stats Engine von Optimizely verwendet auch eine Variante der Empirical Bayesian Technik. Sie vereint das Beste aus frequentistischen und Bayes'schen Methoden und bietet gleichzeitig die immer gültige Garantie für eine kontinuierliche Überwachung der Ergebnisse von Experimenten.

Stats Engine benötigt mehr Beweise, um ein signifikantes Ergebnis zu erzielen, was es Experimentierern ermöglicht, während der Laufzeit eines Experiments so oft zu schauen, wie sie möchten. Stats Engine kontrolliert außerdem jederzeit Ihre Falsch-positiv-Raten, unabhängig davon, wann oder wie oft Sie nachschauen, und passt sich darüber hinaus an Situationen an, in denen Ihr Experiment mehrere Vergleiche hat (d.h. mehrere Metriken und Variationen).

Die Kontrolle der Falschentdeckungsrate bietet eine Möglichkeit, die Aussagekraft zu erhöhen und gleichzeitig eine prinzipielle Begrenzung des Fehlers beizubehalten. Anders ausgedrückt: Die Falschentdeckungsrate ist die Wahrscheinlichkeit, dass ein harmloser Befund als "Wolf" bezeichnet wird.

Daher ermöglicht die Stats Engine eine kontinuierliche Überwachung der Ergebnisse mit stets gültigen Resultaten, indem sie die False-Positive-Rate jederzeit kontrolliert, unabhängig davon, wann oder wie oft der Experimentator einen Blick auf die Ergebnisse wirft.

Zusammenfassend...

Es gibt keinen "besten" statistischen Ansatz, sondern nur das richtige Tool für Ihre Situation.

Die meisten Unternehmen brauchen sich nicht um die perfekte statistische Implementierung zu kümmern. Sie müssen es:

- einen Ansatz wählen, der zu ihren geschäftlichen Zwängen passt

- ihn richtig implementieren

- Ihn konsequent nutzen

- sich darauf konzentrieren, die richtigen Fragen zu stellen

Das Ziel ist nicht statistische Reinheit. Es geht darum, gute Geschäftsentscheidungen zu treffen, die effizient auf zuverlässigen Beweisen basieren.

Denken Sie daran, dass keine statistische Methode Sie vor einem schlechten Design eines Experiments oder vor irrelevanten Messwerten bewahren kann. Die beste Statistik der Welt kann einen Test nicht verbessern, der für Ihre Benutzer nicht von Bedeutung ist.

Sind Sie bereit, Ihr nächstes Experiment zu planen?

Testen Sie unseren Stichprobengrößenrechner, um sicherzustellen, dass Sie genügend Daten für zuverlässige Ergebnisse sammeln.