A/B-Testing

Was ist A/B-Testing?

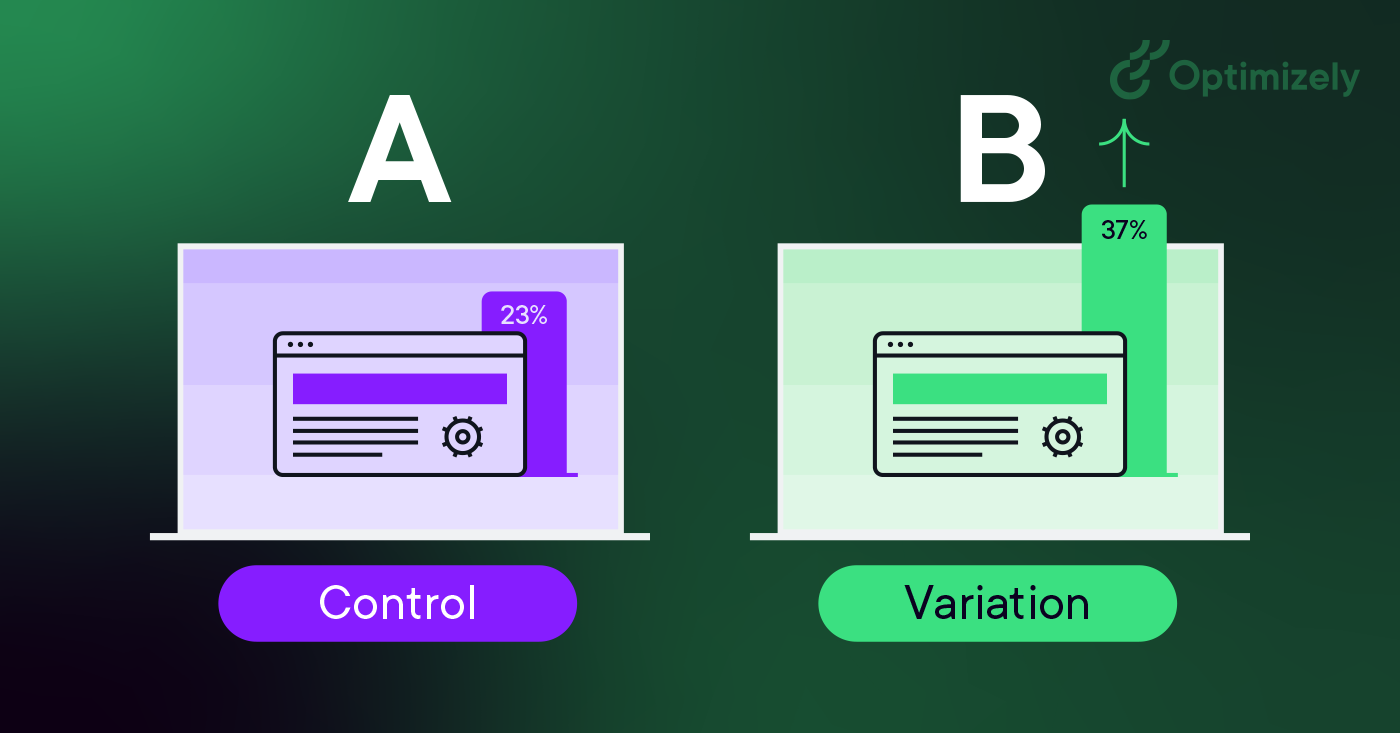

A/B-Testing (auch bekannt als Split-Testing oder Bucket-Testing) ist eine Methode, bei der zwei Versionen einer Webseite oder App miteinander verglichen werden, um festzustellen, welche Variante besser abschneidet. Dabei werden den Nutzern nach dem Zufallsprinzip zwei Varianten einer Seite gezeigt, und mithilfe einer statistischen Analyse wird ermittelt, welche Variante bessere Ergebnisse für Ihre Conversion-Ziele erzielt.

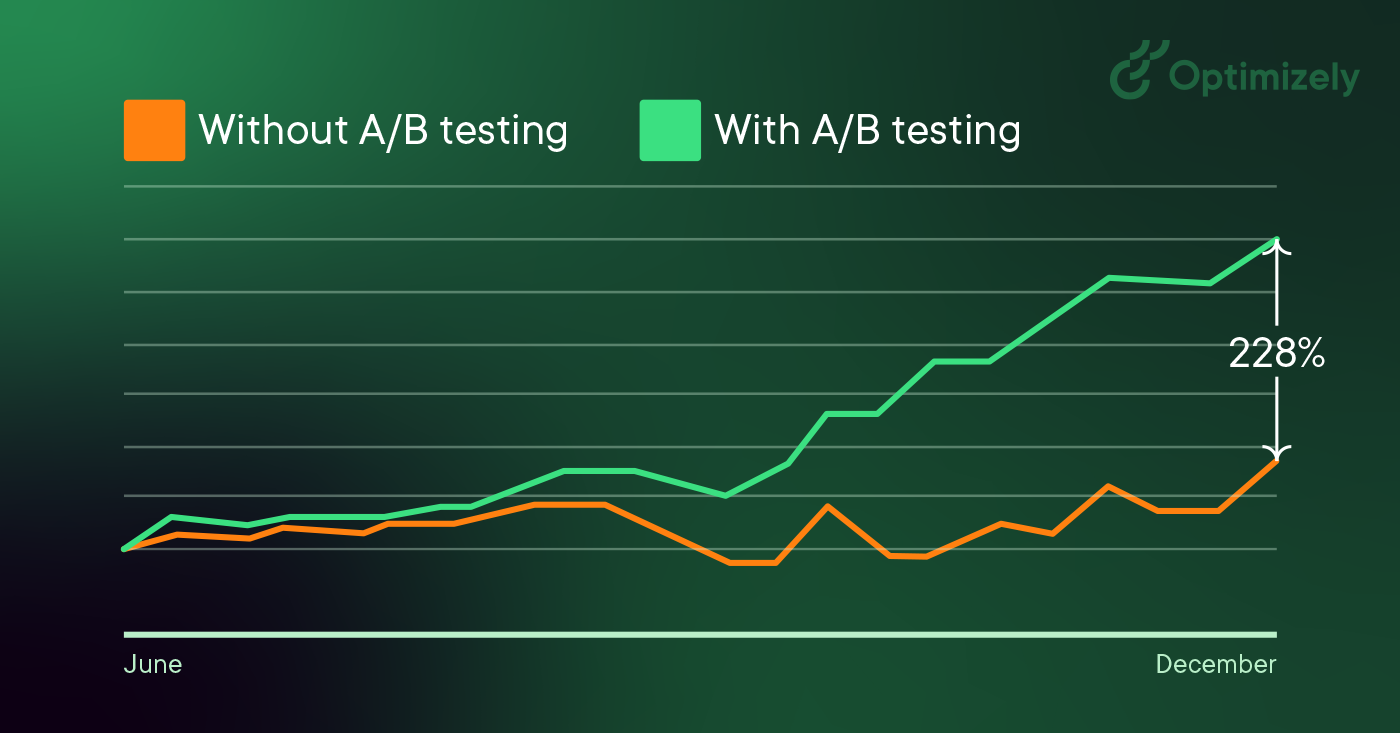

Bildquelle: Optimizely

In der Praxis funktioniert das A/B-Testing so:

- Sie erstellen zwei Versionen einer Seite - das Original (Kontrolle oder A) und eine modifizierte Version (Variation oder B).

- Verteilen Sie Ihren Traffic nach dem Zufallsprinzip auf diese Versionen

- Messung der Benutzerinteraktion über ein Dashboard

- Analysieren Sie die Ergebnisse, um festzustellen, ob die Änderungen positive, negative oder neutrale Auswirkungen hatten.

Die Änderungen, die Sie testen, können von einfachen Anpassungen (wie einer Überschrift oder einer Schaltfläche) bis hin zu kompletten Neugestaltungen der Seite reichen. Durch die Messung der Auswirkungen jeder Änderung verwandelt A/B-Testing die Website-Optimierung von einer Vermutung in eine datengestützte Entscheidung und verlagert die Konversation von "wir denken" zu "wir wissen".

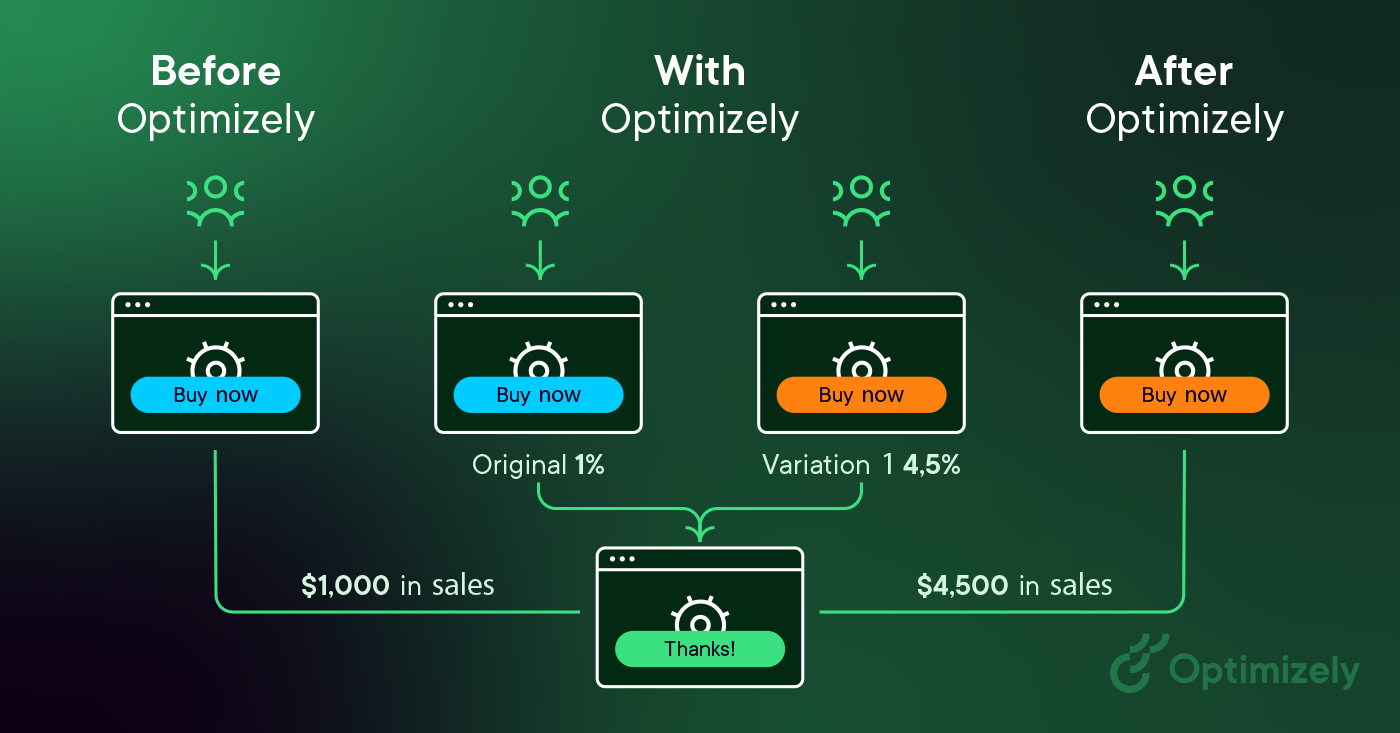

Bildquelle: Optimizely

Während den Besuchern entweder die Kontrollversion oder die Variation angeboten wird, wird ihr Interesse an den einzelnen Erlebnissen gemessen, in einem Dashboard gesammelt und mit Hilfe einer Statistikmaschine analysiert. Sie können dann feststellen, ob die Änderung des Erlebnisses (Variation oder B) einen positiven, negativen oder neutralen Effekt im Vergleich zur Grundlinie (Kontrolle oder A) hatte.

Bildquelle: Optimizely

"Das Konzept des A/B-Testing ist einfach: Zeigen Sie verschiedenen Personen unterschiedliche Varianten Ihrer Website und messen Sie, welche Variante am effektivsten ist, um sie in Kunden zu verwandeln."

Dan Siroker und Pete Koomen (Buch | A/B-Testing: Der effektivste Weg, Klicks in Kunden zu verwandeln)

Warum Sie A/B-Tests durchführen sollten

A/B-Testing ermöglicht es Einzelpersonen, Teams und Unternehmen, vorsichtige Änderungen an ihren Erlebnissen vorzunehmen und gleichzeitig Daten über deren Auswirkungen zu sammeln. So können sie Hypothesen aufstellen und erfahren, welche Elemente und Optimierungen ihrer Erlebnisse das Nutzerverhalten am stärksten beeinflussen. Auf eine andere Art und Weise können sie auch eines Besseren belehrt werden - ihre Meinung über das beste Erlebnis für ein bestimmtes Ziel kann durch ein A/B-Testing widerlegt werden.

A/B-Testing dient nicht nur dazu, eine einmalige Frage zu beantworten oder eine Unstimmigkeit zu beseitigen, sondern kann auch dazu verwendet werden, ein bestimmtes Erlebnis oder ein einzelnes Ziel wie die Conversion Rate Optimization (CRO) im Laufe der Zeit kontinuierlich zu verbessern.

Beispiele für A/B-Testing-Anwendungen:

- B2B Leadgenerierung: Wenn Sie ein Technik-Unternehmen sind, können Sie Ihre Landing Pages verbessern, indem Sie Änderungen an Überschriften, Formularfeldern und CTAs testen. Indem Sie ein Element nach dem anderen testen, können Sie feststellen, welche Änderungen die Qualität der Leads und die Conversion Rate erhöhen.

- Kampagnenleistung: Wenn Sie eine Produktmarketing-Kampagne durchführen, können Sie die Ausgaben für Anzeigen optimieren, indem Sie sowohl Anzeigentexte als auch Landing Pages testen. Durch das Testen verschiedener Layouts konnten Sie beispielsweise herausfinden, welche Version Besucher am effizientesten in Kunden umwandelt und so die Gesamtkosten für die Kundenakquise reduziert.

- Produkt-Erlebnisse: Die Produktteams in Ihrem Unternehmen können A/B-Tests nutzen , um Annahmen zu validieren, wichtige Funktionen zu priorisieren und Produkte ohne Risiken zu liefern. Von Onboarding-Flows bis hin zu produktinternen Benachrichtigungen - Tests helfen, das Erlebnis für den Benutzer zu optimieren und gleichzeitig klare Ziele und Hypothesen aufrechtzuerhalten.

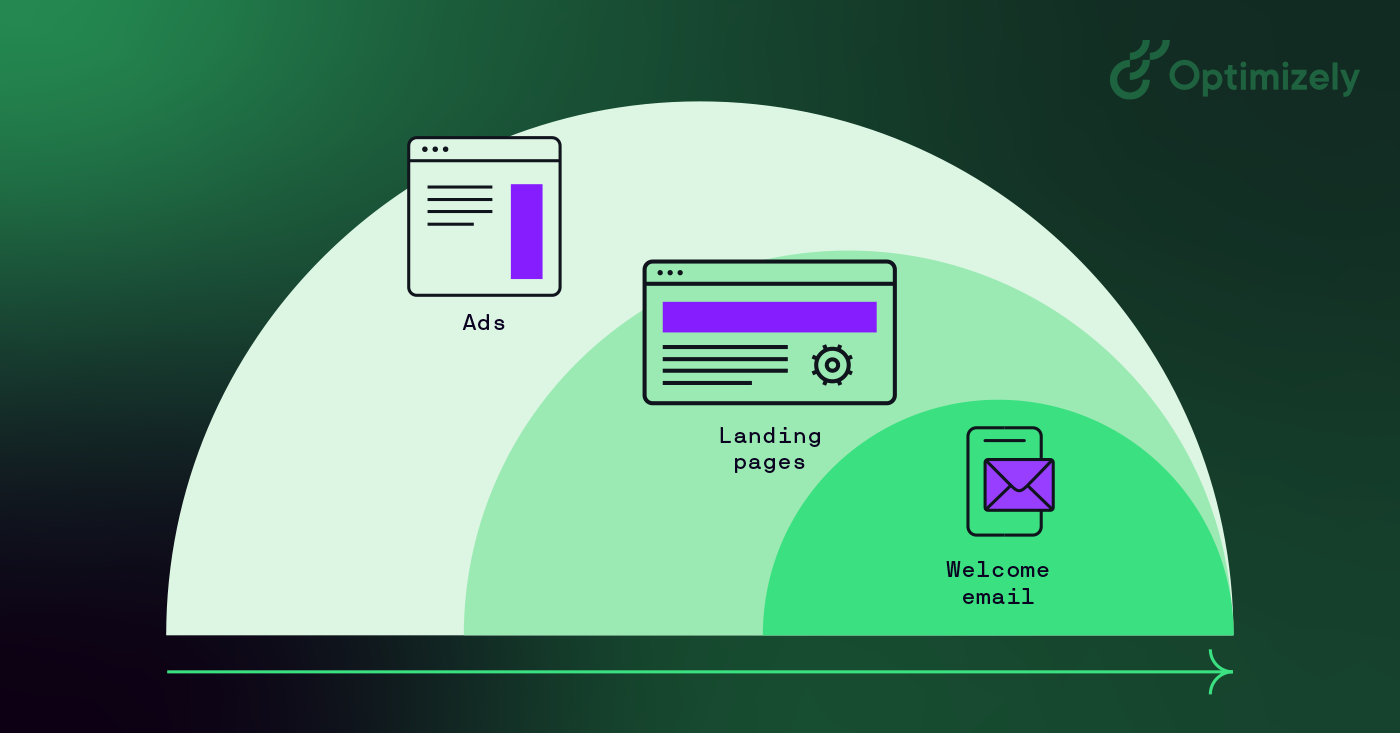

Bildquelle: Optimizely

A/B-Testing hilft dabei, die Entscheidungsfindung von meinungsbasierten zu datengesteuerten Entscheidungen umzuwandeln und den HiPPO-Slang (Highest Paid Person's Opinion) in Frage zu stellen.

Wie Dan Siroker bemerkt: "Es geht darum, bescheiden zu sein... vielleicht wissen wir gar nicht, was am besten ist, lassen Sie uns die Daten betrachten und uns von ihnen leiten."

Wie man A/B-Tests durchführt

Nachfolgend finden Sie einen Rahmen für A/B-Tests, mit dem Sie anfangen können, Tests durchzuführen:

1. Sammeln Sie Daten

- Verwenden Sie Analysetools wie Google Analytics, um Möglichkeiten zu identifizieren

- Konzentrieren Sie sich mithilfe von Heatmaps auf Bereiche mit hohem Besucheraufkommen.

- Suchen Sie nach Seiten mit hohen Absprungraten

2. Setzen Sie klare Ziele

- Definieren Sie spezifische Metriken zur Verbesserung

- Legen Sie Messkriterien fest

- Setzen Sie sich ein Targeting für Verbesserungen

3. Erstellen Sie Testhypothesen

- Bilden Sie klare Vorhersagen

- Ideen auf vorhandene Daten stützen

- Prioritäten nach potenziellen Auswirkungen setzen

4. Entwerfen Sie Variationen

- Nehmen Sie spezifische, messbare Änderungen vor

- Sorgen Sie für eine angemessene Nachverfolgung

- Testen Sie die technische Implementierung

5. Führen Sie das Experiment durch

- Teilen Sie den Verkehr zufällig auf

- Überwachen Sie auf Probleme

- Sammeln Sie systematisch Datenerfassung

6. Analysieren Sie die Ergebnisse

- Prüfen Sie die statistische Signifikanz

- Überprüfen Sie alle Metriken

- Dokumentieren Sie die gewonnenen Erkenntnisse

Bildquelle: Optimizely

Wenn Ihre Variante gewinnt, fantastisch! Wenden Sie diese Erkenntnisse auf ähnliche Seiten an und setzen Sie die Iteration fort, um auf Ihrem Erfolg aufzubauen. Aber denken Sie daran - nicht jeder Test wird ein Gewinner sein, und das ist völlig in Ordnung.

Beim A/B-Testing gibt es keine wirklichen Misserfolge, sondern nur Gelegenheiten zum Lernen. Jeder Test, egal ob er positive, negative oder neutrale Ergebnisse zeigt, liefert wertvolle Erkenntnisse über Ihre Nutzer und hilft Ihnen, Ihre Teststrategie zu verfeinern.

Mehr über fehlgeschlagene A/B-Tests: Wie Fehlschläge Sie zum Erfolg führen können

Beispiele für A/B-Tests

Hier sind zwei Beispiele für A/B-Tests in Aktion.

1. Homepage A/B-Testing

Felix und Michiel aus dem Digitalteam haben beschlossen, unser Kreativ- und Messagingkonzept auf unserer Homepage mit einer pfötchenähnlichen Überraschung zu versehen.

Bildquelle: Optimizely

Ihr Targeting bestand darin, das Engagement der Benutzer zu steigern.

Die Antwort war in diesem Fall, wie das Team herausfand, eine Menge Wuffis.

Während des Experiments erhielten Website-Besucher, die den Hund auf der Startseite der Website streichelten, einen Link zu unserem Bericht "Evolution des Experimentierens".

Allerdings sehen Sie den Hund nur 50 % der Zeit.

Ergebnis: Personen, die dem Hund ausgesetzt waren, konsumierten den Inhalt 3x mehr als diejenigen, die den Hund nicht sahen.

2. Von Pop-up zu Flop-up

Ronnie Cheung, Senior Strategy Consultant, Optimizely, wollte ein Popup-Fenster für die Details der Einrichtung auf der Kartenansicht einführen, da die Benutzer beim Klicken auf die Stecknadeln auf der Kartenansicht auf eine PDP-Seite weitergeleitet wurden, die einen zusätzlichen Schritt zum Abschluss des Checkouts erforderte.

- Ergebnis: Es kamen weniger Nutzer auf die Checkout-Seite.

- Fazit: Verbessern Sie die Popup-Informationen, damit die Benutzer sicher zum Checkout gehen können.

Wenn Sie mehr sehen möchten, finden Sie hier eine branchenspezifische Liste von A/B-Testing Anwendungsfällen und Beispielen.

Und für Erfolgsgeschichten schauen Sie sich das große Buch des Experimentierens an. Es enthält mehr als 40 Fallstudien zu den Herausforderungen und den Hypothesen, mit denen sie gelöst wurden.

Schaffung einer Kultur des A/B-Testing

Gute Digital Marketing Teams stellen sicher, dass sie mehrere Abteilungen in ihr Experimentieren einbeziehen. Wenn Sie über verschiedene Abteilungen und Berührungspunkte hinweg testen, können Sie die Sicherheit erhöhen, dass die Änderungen, die Sie an Ihrem Marketing vornehmen, statistisch signifikant sind und sich positiv auf Ihr Endergebnis auswirken.

Anwendungsfälle sind unter anderem:

- A/B-Testing von sozialen Medien: Posting-Timing, Inhaltsformate, Variationen der Anzeigengestaltung, Targeting der Zielgruppe, Kampagnenbotschaften

- A/B-Testing im Marketing: E-Mail-Kampagnen, Landing Pages, Anzeigentexte und -motive, Call-to-Action-Schaltflächen, Formulardesigns

- A/B-Testing von Websites: Navigationsdesign, Seitenlayouts, Präsentation von Inhalten, Checkout-Prozesse, Suchfunktionen

Aber Sie können Ihr Programm nur skalieren, wenn Sie eine Test- und Lernkultur aufbauen. Hier erfahren Sie, wie Sie eine Experimentierkultur aufbauen können:

1. Unterstützung durch die Führung

- Demonstrieren Sie den Wert durch erste Erfolge

- Teilen Sie Erfolgsgeschichten

- Verknüpfen Sie die Ergebnisse mit den Geschäftszielen

2. Befähigung des Teams

- Stellen Sie die notwendigen Werkzeuge bereit

- Schulungen anbieten

- Ermutigen Sie zur Hypothesenbildung

3. Prozess-Integration

- Machen Sie das Testen zum Bestandteil des Entwicklungsprozesses

- Erstellen Sie klare Testprotokolle

- Dokumentieren und teilen Sie Ihre Erkenntnisse

Metriken für A/B-Tests

A/B-Testing erfordert Analysen, die mehrere Arten von Metriken verfolgen können und gleichzeitig eine Verbindung zu Ihrem Data Warehouse herstellen, um tiefere Einblicke zu erhalten.

Für den Anfang finden Sie hier, was Sie messen können:

- Primäre Erfolgsmetriken: Conversion Rate, Click-Through-Rate, Umsatz pro Besucher, durchschnittlicher Bestellwert

- Unterstützende Indikatoren: Verweildauer auf der Seite, Bounce-Rate, Seiten pro Sitzung, User Journey-Muster

- Technische Leistung: Ladezeit, Fehlerraten, mobile Reaktionsfähigkeit, Browserkompatibilität

Was wirklich den Unterschied ausmacht, ist die native Analytik von Warehouse. Damit behalten Sie die volle Kontrolle über den Speicherort Ihrer Daten, da Sie Ihre Testdaten im Haus behalten. Außerdem können Sie anhand echter Geschäftsergebnisse testen und automatisierte Kohortenanalysen durchführen. Es ermöglicht nahtlose kanalübergreifende Tests mit einer einzigen Wahrheitsquelle und sorgt gleichzeitig für strikte Data Governance und Compliance.

A/B-Testing-Ergebnisse verstehen

Die Testergebnisse variieren je nach Art und Zielsetzung Ihres Unternehmens. Während sich E-Commerce Sites zum Beispiel auf Kaufmetriken konzentrieren, legen B2B-Unternehmen vielleicht den Schwerpunkt auf Metriken zur Leadgenerierung. Unabhängig davon, worauf Sie sich konzentrieren, sollten Sie mit klaren Zielen beginnen, bevor Sie Ihren Test starten.

Wenn Sie zum Beispiel eine CTA-Schaltfläche testen, werden Sie sehen:

- Anzahl der Besucher, die jede Variante gesehen haben

- Klicks auf jede Variante

- Conversion Rate (Prozentsatz der Besucher, die geklickt haben)

- Statistische Signifikanz des Unterschieds

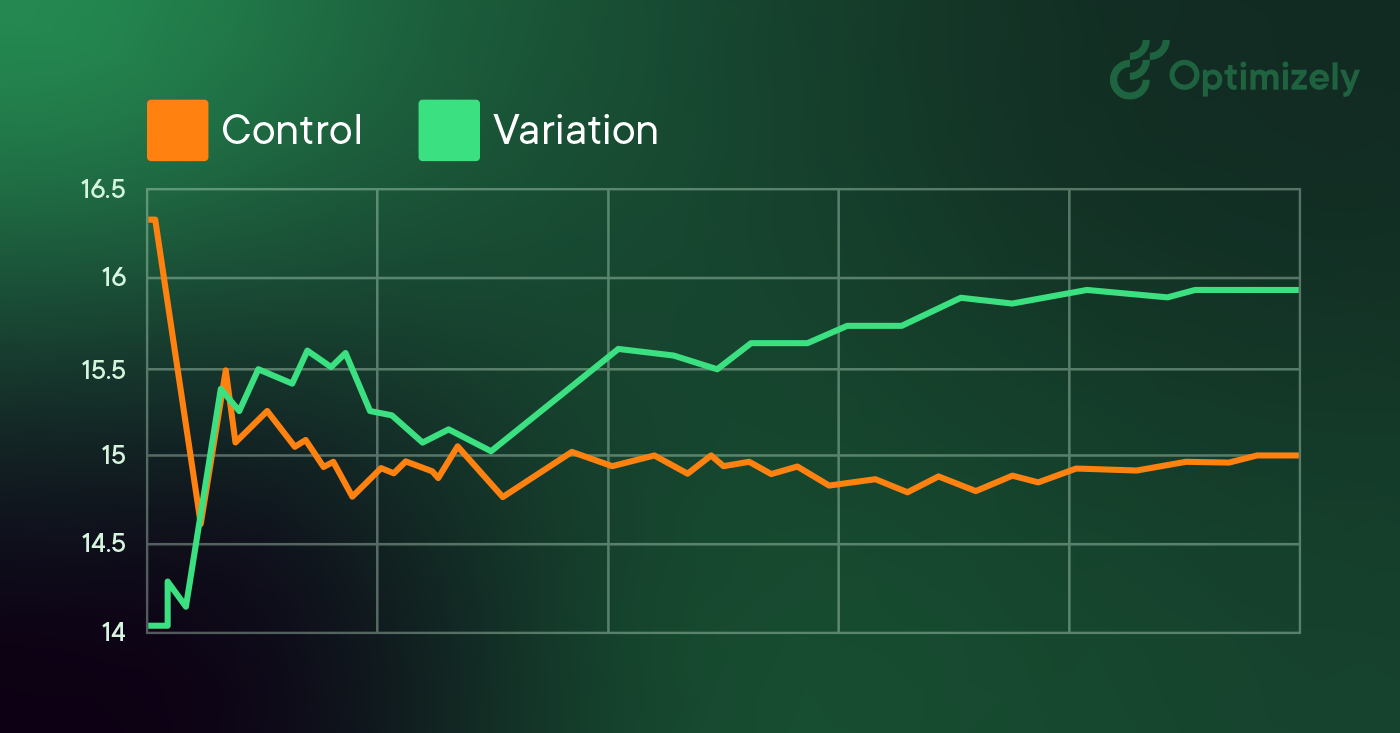

Bildquelle: Optimizely

Wenn Sie A/B-Tests durchführen und die Ergebnisse analysieren, können Sie anhand der statistischen Signifikanz feststellen, ob Ihre Testergebnisse verlässlich sind oder nur dem Zufall unterliegen.

Wenn Sie die Ergebnisse analysieren:

- Vergleichen Sie mit Ihrer Basislinie (A-Version)

- Suchen Sie nach einer statistisch signifikanten Verbesserung

- Berücksichtigen Sie die praktischen Auswirkungen der Verbesserung

- Prüfen Sie, ob die Ergebnisse mit anderen Metriken übereinstimmen.

Segmentierung von A/B-Tests

Größere Sites und Apps verwenden für ihre A/B-Tests häufig eine Segmentierung. Wenn Ihre Besucherzahl hoch genug ist, ist dies eine wertvolle Methode, um Änderungen für bestimmte Besuchergruppen zu testen. Eine gängige Segmentierung für A/B-Tests ist die Aufteilung zwischen neuen und wiederkehrenden Besuchern. So können Sie Änderungen an Elementen testen, die nur für neue Besucher gelten, z.B. Anmeldeformulare.

Ein häufiger Fehler beim A/B-Testing ist es jedoch, zu kleine Zielgruppen für Tests zu erstellen. Also:

- Segmentieren Sie nur, wenn Sie genügend Besucher haben

- Beginnen Sie mit allgemeinen Segmentierungen (neue vs. wiederkehrende Besucher)

- Stellen Sie sicher, dass die Größe der Segmentierung die statistische Signifikanz unterstützt.

- Vermeiden Sie die Erstellung zu vieler kleiner Segmente, die zu falsch positiven Ergebnissen führen könnten.

A/B-Testing & SEO

Google erlaubt und fördert A/B-Tests und hat erklärt, dass die Durchführung von A/B- oder multivariaten Tests kein Risiko für das Suchranking Ihrer Website darstellt. Es ist jedoch möglich, Ihren Suchrang zu gefährden, wenn Sie ein A/B-Testing-Tool für Zwecke wie Cloaking missbrauchen. Google hat einige Erfolgsmethoden formuliert, um sicherzustellen, dass dies nicht passiert:

-

Kein Cloaking: Unter Cloaking versteht man die Praxis, Suchmaschinen andere Inhalte anzuzeigen, als ein typischer Besucher sehen würde. Cloaking kann dazu führen, dass Ihre Site zurückgestuft oder sogar aus den Suchergebnissen entfernt wird. Um Cloaking zu verhindern, sollten Sie die Segmentierung der Besucher nicht missbrauchen, um dem Googlebot je nach User-Agent oder IP-Adresse unterschiedliche Inhalte anzuzeigen.

-

Verwenden Sie rel="canonical": Wenn Sie einen Split-Test mit mehreren URLs durchführen, sollten Sie das Attribut rel="canonical" verwenden, um die Variationen auf die Originalversion der Seite zurückzuführen. Auf diese Weise verhindern Sie, dass Googlebot durch mehrere Versionen derselben Seite verwirrt wird.

-

Verwenden Sie 302-Weiterleitungen anstelle von 301-Weiterleitungen: Wenn Sie einen Test durchführen, bei dem die Original-URL auf eine Variations-URL umgeleitet wird, verwenden Sie eine 302er (temporäre) Umleitung im Gegensatz zu einer 301er (permanenten) Umleitung. Dies teilt Suchmaschinen wie Google mit, dass die Weiterleitung vorübergehend ist und dass sie die Original-URL und nicht die Test-URL indiziert lassen sollten.

Ein Medienunternehmen möchte vielleicht die Zahl der Leser erhöhen, die Verweildauer der Leser auf seiner Site steigern und seine Artikel über soziale Netzwerke verbreiten. Um diese Ziele zu erreichen, könnten sie Varianten testen:

- E-Mail-Anmeldemodale

- Empfohlene Inhalte

- Schaltflächen für soziale Netzwerke

Ein Reiseunternehmen möchte vielleicht die Anzahl der erfolgreichen Buchungen über seine Website oder Mobile App erhöhen oder die Einnahmen aus Zusatzkäufen steigern. Um diese Metriken zu verbessern, können sie Variationen von:

- Homepage-Suchmodalen

- Seite mit den Suchergebnissen

- Präsentation zusätzlicher Produkte

Ein E-Commerce-Unternehmen möchte vielleicht das Erlebnis für seine Kunden verbessern, indem es die Anzahl der abgeschlossenen Checkouts, den durchschnittlichen Bestellwert oder den Umsatz im Weihnachtsgeschäft erhöht. Um dies zu erreichen, können sie A/B-Tests durchführen:

- Homepage-Aktionen

- Navigationselemente

- Komponenten des Checkout-Trichters

Ein Technik-Unternehmen möchte vielleicht die Zahl der hochwertigen Leads für sein Vertriebsteam erhöhen, die Zahl der Nutzer von kostenlosen Testversionen steigern oder einen bestimmten Käufertyp ansprechen. Sie könnten testen:

- Lead-Formularfelder

- Ablauf der Anmeldung für die kostenlose Testversion

- Homepage-Botschaften und Call-to-Action

Drei Schlussfolgerungen

Das können Sie auf Ihr A/B-Testing-Programm anwenden:

- Sie können das Kundenverhalten nicht rationalisieren.

- Keine Idee ist zu groß, zu clever oder zu 'Erfolgsmethode', als dass sie nicht getestet werden könnte.

- Die komplette Neugestaltung einer Website von Grund auf ist nicht der richtige Weg. Gehen Sie ins Detail, aber fangen Sie klein an.

Denken Sie daran, dass Tests eine unglaublich wertvolle Gelegenheit sind, um zu erfahren, wie Kunden mit Ihrer Website interagieren. Beginnen Sie jetzt mit Optimizely Web Experimentation.