A/B-testning

Vad är A/B-testning?

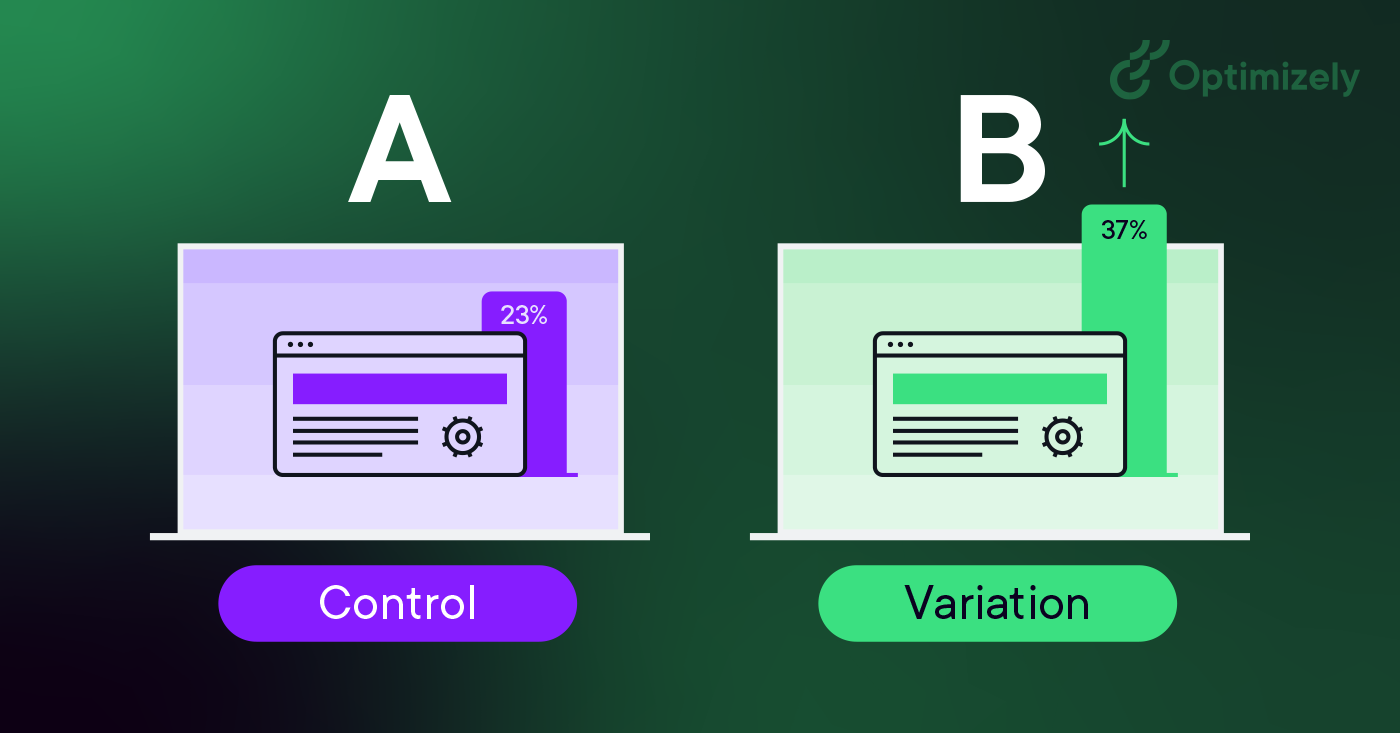

A/B-testning (även känd som split testing eller bucket testing) är en metod för att jämföra två versioner av en webbsida eller app mot varandra för att avgöra vilken som presterar bäst. Det fungerar genom att slumpmässigt visa två varianter av en sida för användare och använda statistisk analys för att avgöra vilken variant som ger bäst resultat för dina mål för konvertering.

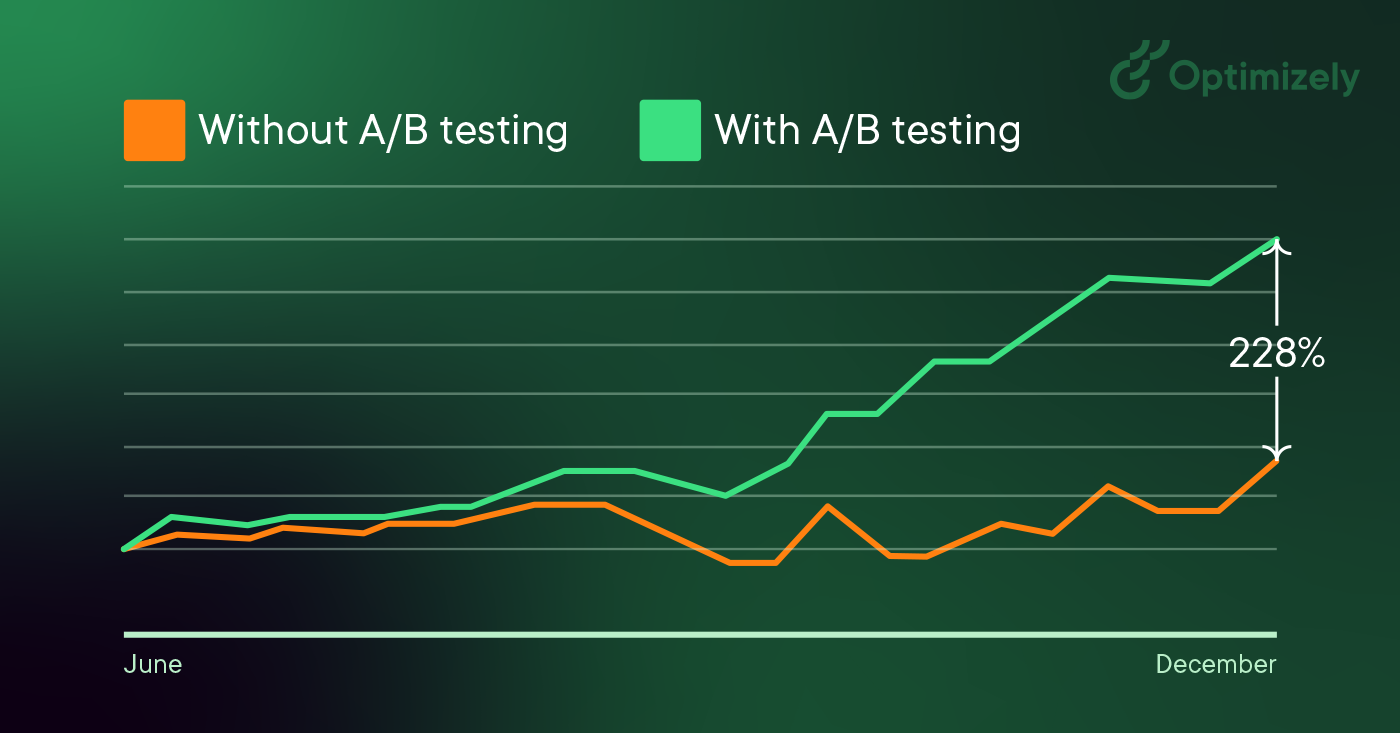

Bildkälla: Optimizely

I praktiken är det så här A/B-testning fungerar:

- Skapa två versioner av en sida - originalet (kontroll eller A) och en modifierad version (variation eller B)

- Slumpmässigt dela upp din trafik mellan dessa versioner

- Mät användarengagemanget via en dashboard

- Analysera resultaten för att avgöra om ändringarna hade positiva, negativa eller neutrala effekter

De ändringar du testar kan vara allt från enkla justeringar (som en rubrik eller knapp) till fullständiga omarbetningar av sidan. Genom att mäta effekten av varje förändring förvandlar A/B-testning webbplatsoptimering från gissningar till datainformerade beslut, vilket gör att samtalen går från "vi tror" till "vi vet".

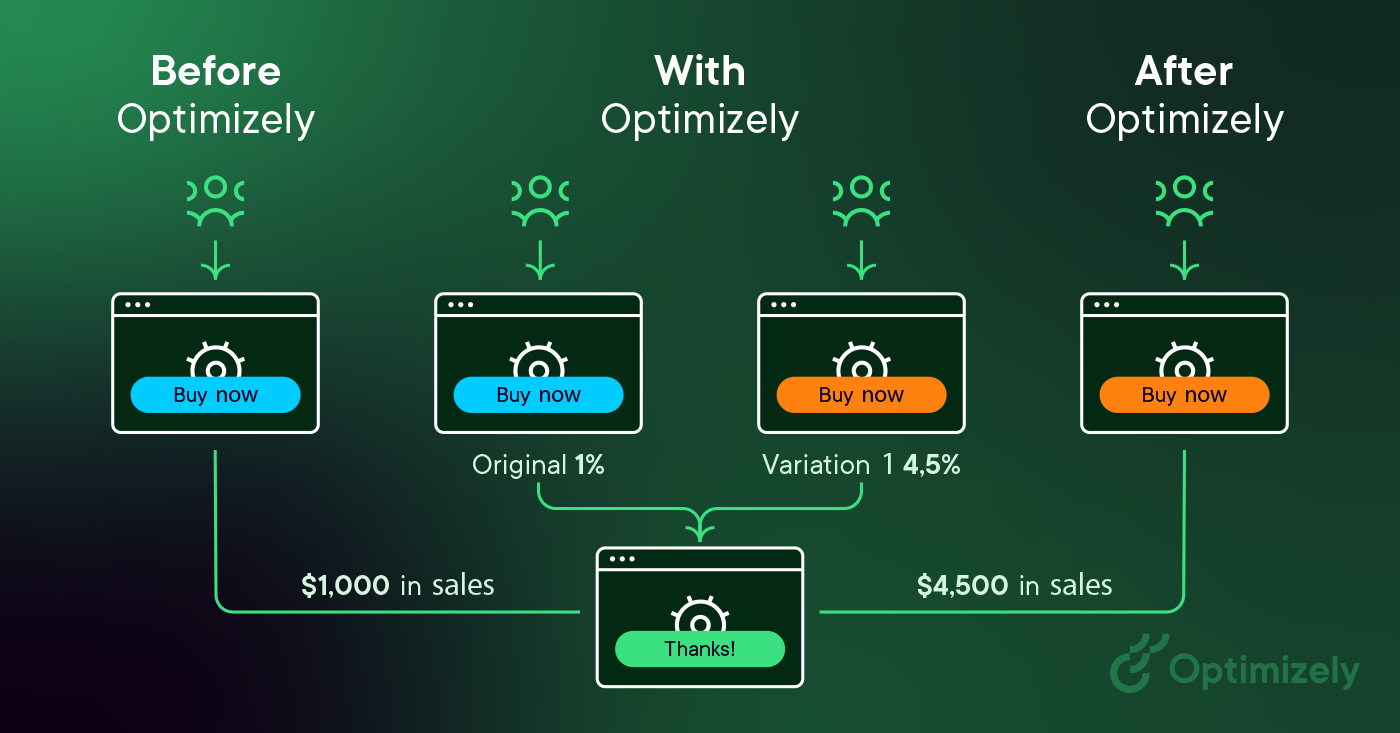

Bildkälla: Optimizely

När besökare serveras antingen kontrollen eller variationen mäts och samlas deras engagemang i varje upplevelse i en dashboard och analyseras genom en statistisk motor. Du kan sedan avgöra om förändringen av upplevelsen (variation eller B) hade en positiv, negativ eller neutral effekt jämfört med baslinjen (kontroll eller A).

Bildkälla: Optimizely Optimizely

"Konceptet med A/B-testning är enkelt: visa olika varianter av din webbplats för olika personer och mät vilken variant som är mest effektiv för att göra dem till kunder."

Dan Siroker och Pete Koomen(bok | A/B-testning: Det mest kraftfulla sättet att förvandla klick till kunder)

Varför du bör göra A/B-testning

A/B-testning gör det möjligt för individer, team och företag att göra noggranna ändringar i sina användarupplevelser samtidigt som de samlar in data om vilken inverkan det har. Detta gör det möjligt för dem att konstruera hypoteser och lära sig vilka element och optimeringar av deras upplevelser som påverkar användarnas beteende mest. På ett annat sätt kan de bevisas ha fel - deras åsikt om den bästa upplevelsen för ett visst mål kan bevisas vara felaktig genom en A/B-testning.

Mer än att bara svara på en engångsfråga eller lösa en oenighet kan A/B-testning användas för att kontinuerligt förbättra en viss upplevelse eller förbättra ett enda mål som konverteringsoptimering (CRO) över tid.

Exempel på tillämpningar av A/B-testning:

- Generera leads inom B2B: Om du är ett företag inom teknik kan du förbättra dina landningssidor genom att testa ändringar av rubriker, formulärfält och CTA:er. Genom att testa ett element i taget kan du identifiera vilka förändringar som ökar kvaliteten på leads och konverteringsgraden.

- Kampanjprestanda: Om du är en marknadsförare som driver en produktmarknadsföringskampanj kan du optimera annonsutgifterna genom att testa både annonstexter och landningssidor. Genom att testa olika layouter kunde man till exempel identifiera vilken version som konverterade besökare till kunder mest effektivt, vilket minskade de totala kostnaderna för kundförvärv.

- Produktupplevelse: Produktteamen i ditt företag kan använda A/B-testning för att validera antaganden, prioritera funktioner som är viktiga och leverera produkter utan risker. Från onboardingflöden till produktmeddelanden hjälper testning till att optimera användarupplevelsen samtidigt som tydliga mål och hypoteser upprätthålls.

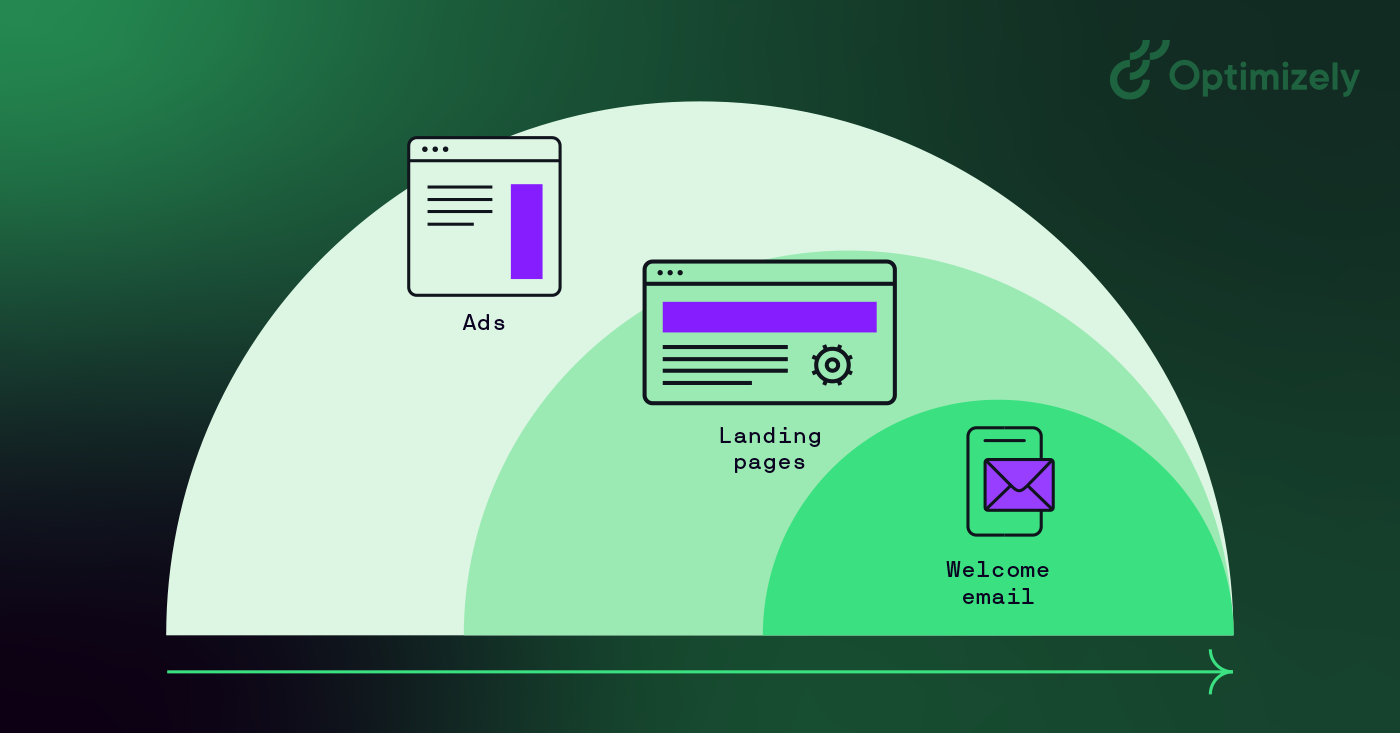

Bildkälla: Optimizely

A/B-testning hjälper till att omvandla beslutsfattande från åsiktsbaserat till datadrivet och utmanar HiPPO-slang (Highest Paid Person's Opinion).

Som Dan Siroker säger: "Det handlar om att vara ödmjuk ... vi kanske inte vet vad som är bäst, låt oss titta på data och använda den för att vägleda oss."

Hur man gör A/B-testning

Följande är ett ramverk för A/B-testning som du kan använda för att börja köra tester:

1. Samla in data

- Använd analysverktyg som Google Analytics för att identifiera möjligheter

- Fokusera på områden med hög trafik genom värmekartor

- Leta efter sidor med hög drop-off-frekvens

2. Sätt upp tydliga mål

- Definiera specifika mätvärden som ska förbättras

- Upprätta mätkriterier

- Ange målgruppsinriktning för förbättringarna

3. Skapa testhypoteser

- Formulera tydliga förutsägelser

- Basera idéer på befintliga data

- Prioritera efter potentiell påverkan

4. Utforma variationer

- Gör specifika, mätbara förändringar

- Säkerställ korrekt spårning

- Testa teknisk implementering

5. Kör experimentet

- Dela upp trafiken slumpmässigt

- Övervaka för att upptäcka problem

- Samla in data systematiskt

6. Analysera resultaten

- Kontrollera statistisk signifikans

- Granska alla mätvärden

- Dokumentera lärdomar

Bildkälla: Optimizely

Om din variation vinner är det fantastiskt! Tillämpa dessa insikter på liknande sidor och fortsätt iterera för att bygga vidare på din framgång. Men kom ihåg - inte alla tester kommer att vara vinnande, och det är helt okej.

I A/B-testning finns det inga riktiga misslyckanden - bara möjligheter att lära sig. Varje test, oavsett om det visar positiva, negativa eller neutrala resultat, ger värdefulla insikter om dina användare och hjälper till att förfina din teststrategi.

Mer om misslyckade A/B-testningar: Hur misslyckade testningar kan leda dig till framgång

Exempel på A/B-testning

Här är två exempel på A/B-testning i praktiken.

1. A/B-testning av startsidan

Felix och Michiel från det digitala teamet bestämde sig för att lägga till en tassig överraskning till vårt kreativa material och budskap på vår hemsida.

Bildkälla: Optimizely

Deras mål var att öka användarengagemanget.

Svaret i det här fallet, upptäckte teamet, var en hel del woofs.

Under experimentet fick webbplatsbesökare som klappade hunden på webbplatsens startsida en länk till vår rapport "Evolution of Experiment".

Du ser dock bara hunden 50 % av tiden.

Resultat: Personer som exponerades för hunden konsumerade innehållet 3x mer än de som inte såg hunden.

2. Pop-up till flop-up

Ronnie Cheung , Senior Strategy Consultant, Optimizely, ville införa en popup-fönster för anläggningsdetaljer på kartvyn eftersom när användare klickade på nålar på kartvyn skulle de tas till en PDP-sida som lade till ett extra steg för att slutföra checkout.

- Resultat: Färre användare gick in på sidan för checkout

- Att ta med sig: Förbättra popup-informationen så att användarna tryggt kan gå vidare till checkout.

Om du vill se mer finns här en branschspecifik lista över användningsfall och exempel på A/B-testning.

Och för framgångshistorier, kolla in den stora boken om experimentering. Den innehåller över 40 fallstudier som visar utmaningarna och de hypoteser som används för att lösa dem.

Skapa en kultur av A/B-testning

Bra team inom Digital Marketer ser till att involvera flera avdelningar i sin experimentering. När du testar på olika avdelningar och kontaktpunkter kan du öka konfidensnivån för att de förändringar du gör i din marknadsföring är statistiskt signifikanta och har en positiv inverkan på slutresultatet.

Användningsfall inkluderar:

- A/B-testning av sociala medier: Tidpunkt för inlägg, innehållsformat, variationer i annonsmaterial, målgruppsinriktning, kampanjmeddelanden

- A/B-testning av marknadsföring: E-postkampanjer, landningssidor, annonstexter och annonser, call to action-knappar, formulärdesign

- A/B-testning av webbplats: Navigationsdesign, sidlayouter, innehållspresentation, checkout-processer, sökfunktionalitet

Men du kan bara skala upp ditt program om det antar ett test-och-lär-tänk. Så här bygger du en experimenteringskultur:

1. Ledningens stöd

- Demonstrera värde genom tidiga vinster

- Dela med dig av framgångshistorier

- Koppla resultaten till affärsmålen

2. Förstärkning av teamet

- Tillhandahåll nödvändiga verktyg

- Erbjuda utbildning

- Uppmuntra till att skapa hypoteser

3. Integrering av processer

- Gör testning till en del av utvecklingsarbetsflödet

- Skapa tydliga protokoll för testning

- Dokumentera och dela lärdomar

Mätvärden för A/B-testning

A/B-testning kräver analysverktyg som kan spåra flera olika typer av mätvärden och samtidigt ansluta till ditt datalager för djupare insikter.

Till att börja med kan du se vad du kan mäta här:

- Primära framgångsmått: Konverteringsgrad, klickfrekvens, intäkt per besökare, genomsnittligt ordervärde

- Stödjande indikatorer: Tid på sidan, bounce rate, sidor per session, mönster för användarresan

- Teknisk prestanda: Laddningstid, felfrekvenser, mobil respons, webbläsarkompatibilitet

Det som verkligen gör skillnad är warehouse-native analytics. Det gör att du kan behålla full kontroll över dataplatsen genom att hålla dina testdata internt. Dessutom kan du testa mot verkliga affärsresultat och möjliggöra automatiserad kohortanalys. Det ger sömlös omnikanal-testning med en enda sanningskälla samtidigt som strikt datastyrning och regelefterlevnad upprätthålls.

Förstå resultaten av A/B-testning

Testresultaten varierar beroende på typ av verksamhet och mål. Till exempel kan webbplatser för e-handel fokusera på inköpsmätningar, medan B2B-företag kanske prioriterar mätningar för att generera leads. Oavsett vilket fokus du har bör du börja med tydliga mål innan du startar ditt test.

Om du till exempel testar en CTA-knapp kommer du att se

- Antal besökare som såg varje version

- Klick på varje variant

- Konverteringsgrad (procentandel av besökarna som klickade)

- Skillnadens statistiska signifikans

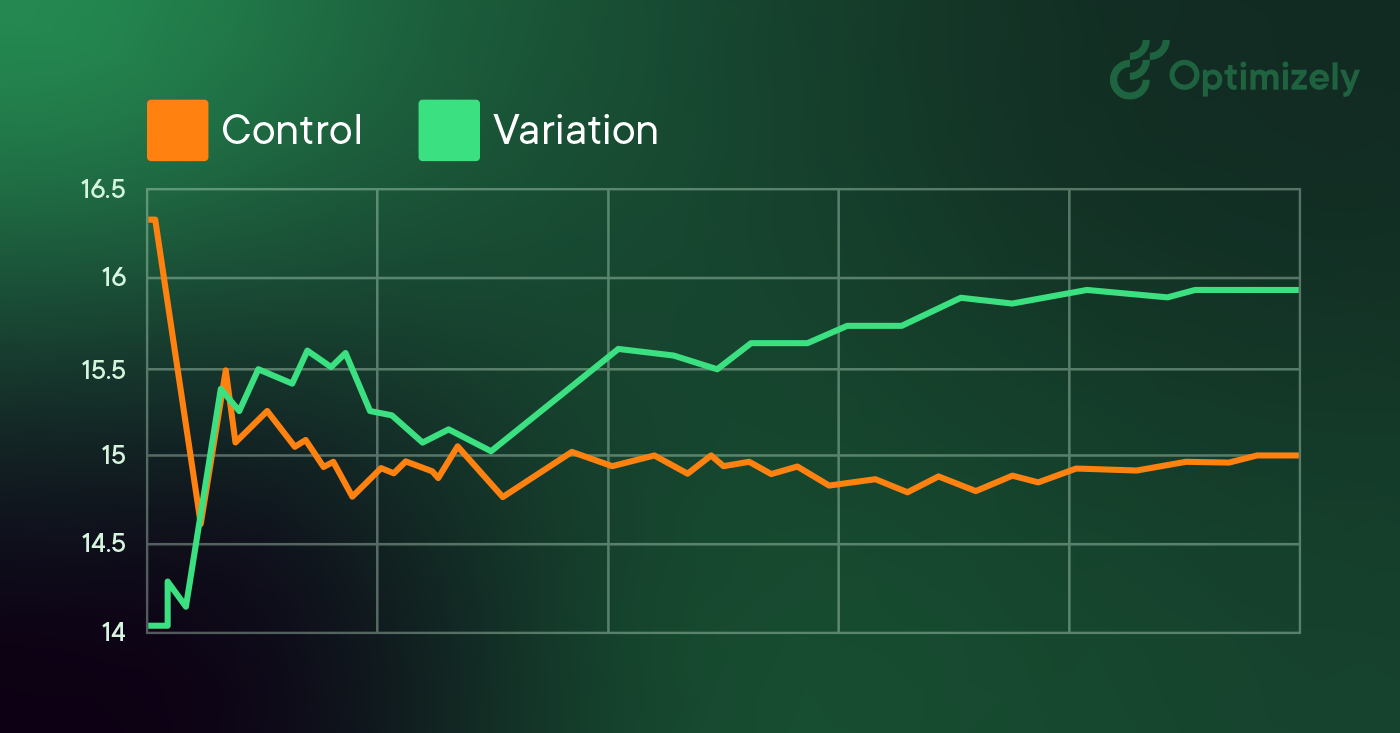

Bildkälla: Optimizely

När du kör A/B-testning och analyserar resultat berättar den statistiska signifikansen om dina testresultat är tillförlitliga eller bara slumpmässiga.

När du analyserar resultat:

- Jämför mot din baslinje (A-version)

- Leta efter en statistisk signifikans

- Beakta förbättringens praktiska inverkan

- Kontrollera om resultaten stämmer överens med andra mätvärden

Segmentering av A/B-testning

Större webbplatser och appar använder ofta segmentering för sina A/B-testningar. Om du har tillräckligt många besökare är detta ett värdefullt sätt att testa förändringar för specifika grupper av besökare. Ett vanligt segment som används för A/B-testning är att dela upp nya besökare mot återkommande besökare. Detta gör att du kan testa ändringar i element som bara gäller nya besökare, till exempel registreringsformulär.

Å andra sidan är ett vanligt misstag vid A/B-testning att skapa målgrupper för tester som är för små. Gör så här:

- Segmentera bara när du har tillräckligt med trafik

- Börja med vanliga segment (nya vs. återkommande besökare)

- Säkerställ att segmentstorleken stöder statistisk signifikans

- Undvik att skapa för många små segment som kan leda till falska positiva resultat

A/B-testning och SEO

Google tillåter och uppmuntrar A/B-testning och har sagt att det inte innebär någon inneboende risk för webbplatsens sökrankning att utföra en A/B- eller multivariat testning. Det är dock möjligt att äventyra din sökrankning genom att missbruka ett verktyg för A/B-testning för ändamål som cloaking. Google har formulerat några bästa praxis för att säkerställa att detta inte händer:

-

Ingen cloaking: Cloaking innebär att man visar sökmotorer annat innehåll än vad en vanlig besökare skulle se. Cloaking kan leda till att din webbplats degraderas eller till och med tas bort från sökresultaten. För att förhindra cloaking ska du inte missbruka segmentering av besökare för att visa olika innehåll för Googlebot baserat på användaragent eller IP-adress.

-

Använd rel="canonical": Om du kör ett split testing med flera webbadresser bör du använda attributet rel="canonical " för att peka tillbaka variationerna till originalversionen av sidan. På så sätt förhindrar du att Googlebot blir förvirrad av flera versioner av samma sida.

-

Använd 302-omdirigeringar istället för 301: Om du kör ett test som omdirigerar original-URL:en till en variations-URL, använd en 302 (tillfällig) omdirigering jämfört med en 301 (permanent) omdirigering. Detta talar om för sökmotorer som Google att omdirigeringen är tillfällig och att de bör hålla original-URL:en indexerad snarare än test-URL:en.

Ett medieföretag kanske vill öka antalet läsare, öka den tid som läsarna tillbringar på webbplatsen och förstärka sina artiklar med social delning. För att uppnå dessa mål kan de testa variationer på:

- Modaler för registrering av e-post

- Rekommenderat innehåll

- Knappar för social delning

Ett reseföretag kanske vill öka antalet bokningar som slutförs på webbplatsen eller i mobilappen, eller öka intäkterna från tilläggsköp. För att förbättra dessa mätvärden kan de testa variationer av:

- Sökmodaler på startsidan

- Sidan med sökresultat

- Presentation av kompletterande produkter

Ett e-handelsföretag kanske vill förbättra sin kundupplevelse, vilket resulterar i en ökning av antalet genomförda checkouts, det genomsnittliga ordervärdet eller en ökad semesterförsäljning. För att åstadkomma detta kan de göra A/B-testning:

- Kampanjer på startsidan

- Navigeringselement

- Komponenter i tratten för checkout

Ett företag inom teknik kanske vill öka antalet högkvalitativa leads för sitt säljteam, öka antalet användare av kostnadsfria testversioner eller attrahera en viss typ av köpare. De kan testa:

- Fält i formulär för leads

- Registreringsflöde för gratis provperiod

- Meddelanden och call to action på hemsidan

Tre saker att ta med sig

Du kan tillämpa på ditt program för A/B-testning:

- Du kan inte rationalisera kundbeteende.

- Ingen idé är för stor, för smart eller för "bästa praxis" för att den inte ska kunna testas.

- Att göra om en webbplats helt från grunden är inte rätt väg att gå. Var specifik, men börja i liten skala.

Kom ihåg att testning är en otroligt värdefull möjlighet att lära sig hur kunderna interagerar med din webbplats. Börja nu med Optimizely Web Experimentation.